Cloud Data Platform Consulting

Starkes Fundament. Starkes Business.

Diese Unternehmen vertrauen

bereits auf unsere Expertise:

Skalierbare Datenplattformen, die Potenziale entfalten

Im Zeitalter rasanter Marktveränderungen entscheidet die Kraft deiner Daten darüber, wie erfolgreich dein Unternehmen agiert. Wir entwickeln mit dir eine Cloud Data Platform, die mit deinen Anforderungen wächst, technologische Trends aufnimmt und deine Daten optimal nutzbar macht – von Anfang an oder als gezielte Weiterentwicklung deiner bestehenden Datenarchitektur.

Mit uns schöpfst du den vollen Wert aus jedem Byte und stellst sicher, dass deine Infrastruktur morgen stärker ist als heute. Unser Anspruch: Wir gestalten Lösungen, die nicht nur mit dem Markt Schritt halten, sondern dir echten Vorsprung verschaffen – passgenau, robust und nachhaltig. So wird jede Datenbasis zum Wachstumsmotor deines Business.

Unsere Cloud Data Platform Services

Data Discovery & Assessment

In fokussierten Workshops analysieren wir deine gesamte Datenlandschaft und decken versteckte Potenziale auf.

Infrastruktur-Assessment

Wir analysieren Cloud-Ressourcen, Pipelines und Betriebsprozesse auf Effizienz, Sicherheit und Skalierbarkeit. Als Ergebnis stehen konkrete Handlungsempfehlungen mit transparentem Business-Impact.

Data Architecture Alignment

Wir entwerfen eine skalierbare Datenarchitektur, die sich an der Unternehmensstrategie orientiert und als Grundlage für deine Datenplattform dient.

Data Integration

Wir verbinden heterogene Quellen und sorgen ein einheitliches Datenmodell. Egal ob monatlich, täglich oder in Near-Realtime: Wir liefern verlässliche Daten für Reporting und AI-Anwendungen und bauen Datensilos ab.

Data Pipeline Development

Wir automatisieren den End-to-End-Datenfluss mit robuster Orchestrierung und testen jede Transformation. Das Ergebnis: Zuverlässige Datenbereitstellung, wenig Wartungsaufwand.

Datenmodellierung

Wir modellieren deine Daten entlang der Geschäftsprozesse nach bewährten Standards und schaffen eine robuste Grundlage für Reporting, Self-Service und Automatisierung.

Infrastruktur-Automatisierung

Wir automatisieren das Ausrollen der Infrastruktur, um Set-ups reproduzierbar, effizient und fehlerfrei bereitzustellen.

Performanceoptimierung

Wir analysieren Performance-Bottlenecks und optimieren technische Stellschrauben – für schnellere Abfragen und geringere Betriebskosten.

Entwicklungsstandardisierung

Wir etablieren Entwicklungsstandards, um nachhaltige, wartbare und skalierbare Lösungen zu schaffen.

Data Quality

Durch automatisierte Data-Tests und Anomalie-Erkennung stellen wir sicher, dass deine Datenbasis stets fehlerfrei, konsistent und geschäftskritisch nutzbar bleibt.

Data Governance

Wir entwickeln ein Governance-Framework, das Compliance, Nachvollziehbarkeit und Sicherheit entlang deiner gesamten Datenwertschöpfungskette sicherstellt.

Security

Wir härten deine Datenplattform nach Security-Best-Practices. Sowohl technisch als auch organisatorisch. Für Daten, die sicher sind und es bleiben.

Schulungen & Coaching

Ob in unser Databricks oder Fabric Schulung oder im individuellen Coaching. Wir befähigen dein Team, Pipelines zu warten und weiterzuentwickeln. Das senkt Abhängigkeiten von externen Dienstleistern und verbessert die langfristige Wartbarkeit deiner Datenplattform.

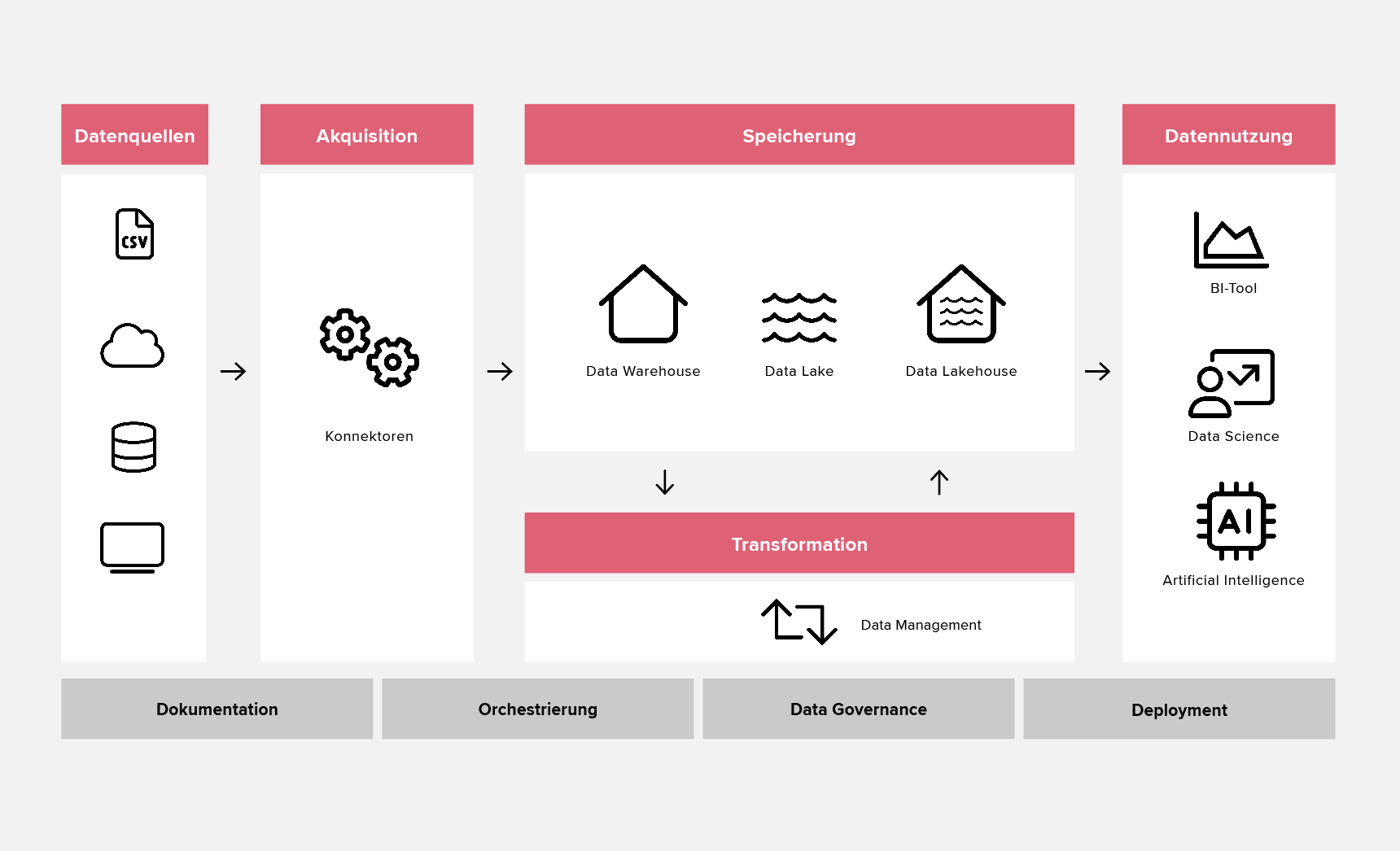

Was deine Data Platform leisten muss – und wie wir das möglich machen.

.svg)

Finde den passenden Service für dich

Data Platform

Nicht das passende Paket für dich dabei?

Schreib uns einfach eine Nachricht und in einem Erstgespräch finden wir gemeinsam heraus, wie wir dir weiterhelfen können.

Wie wir arbeiten – und was du davon hast

Wir helfen dir, dein Reporting zu automatisieren und deine Datenprozesse effizienter zu machen – mit Erfahrung, Hands-on-Mentalität und einem klaren Plan.

Bevor wir loslegen, wollen wir verstehen: dein Setup, deine Ziele, deine Realität. Erst dann gehen wir in die Entwicklung.

Wir entscheiden nicht für Tools – sondern für Lösungen. Wir beraten unabhängig und empfehlen nur, was für dich wirklich Sinn ergibt.

Wir sprechen verständlich – auch bei komplexen technischen Themen.

Wir setzen KI da ein, wo sie sinnvoll ist. So können wir schneller und effizienter Ergebnisse erzielen.

Wie wir arbeiten – und was du davon hast

Wir helfen dir, dein Reporting zu automatisieren und deine Datenprozesse effizienter zu machen – mit Erfahrung, Hands-on-Mentalität und einem klaren Plan.

Bevor wir loslegen, wollen wir verstehen: dein Setup, deine Ziele, deine Realität. Erst dann gehen wir in die Entwicklung.

Wir entscheiden nicht für Tools – sondern für Lösungen. Wir beraten unabhängig und empfehlen nur, was für dich wirklich Sinn ergibt.

Wir sprechen verständlich – auch bei komplexen technischen Themen.

Wir setzen KI da ein, wo sie sinnvoll ist. So können wir schneller und effizienter Ergebnisse erzielen.

Mehr zum Thema Data Warehouse

Cloud Migration

Mit gezielter Planung, modularen Ansätzen und KI-Unterstützung zu nachhaltigem Wachstum und Innovation.

Byte auf Byte

Eröffne deine Möglichkeiten, denn davon hast du viele. Als Inspirationsquelle empfehlen wir dir deine Daten und unsere data!.

Modern Data

Optimiere mit einem modernen Tech Stack deine Dateninfrastruktur.